Google Play Filme & Serien sammelt ein neues HDR-Format ein: Ab sofort sind dort auch Inhalte mit HDR10+ zu haben.

Google hat sich dabei etwas Zeit genommen. Denn angekündigt wurde die Unterstützung von HDR10+ bei Google Play Filme & Serien bereits im Januar 2020. Über ein halbes Jahr hat es also gedauert, bis das dynamische HDR-Format tatsächlich beim Streaming- bzw. On-Demand-Anbieter Einzug gehalten hat. Da war Google sogar mit Dolby Vision schneller, denn Unterstützung für das Konkurrenzformat hagelte es bereits im Mai 2020.

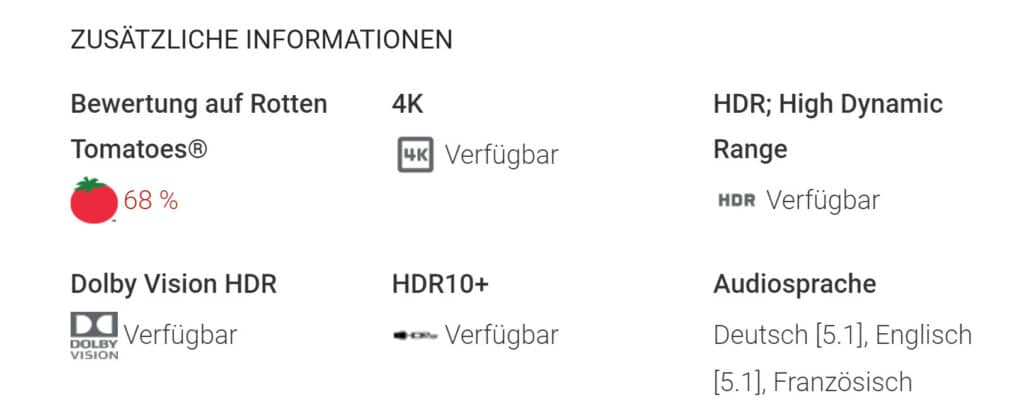

Derzeit ist das Angebot von Filmen mit HDR10+ jedoch noch sehr eingeschränkt. Wir haben auf Anhieb die Filme „Shazam!“, „Crazy Rich Asians“ sowie „Joker“ entdeckt. Letzterer zählte ja auch zu den ersten Filmen, die Dolby Vision bei Google Play Filme & Serien eingebunden haben.

Erwähnenswert ist in diesem Zusammenhang, dass HDR10+ zwar allgemein ein Nischenformat ist und deutlich hinter Dolby Vision zurückstehen muss, HDR10+ aber gerade im mobilen Bereich deutlich präsenter ist, als etwa im Bereich der TVs. Beispielsweise unterstützen Smartphones von OnePlus und Xiaomi HDR10+. Insofern ergibt es durchaus Sinn, das Format im mobilen Segment etwas mehr zu forcieren.

Samsung ist der größte Verfechter von HDR10+

HDR10+ wurde in erster Linie von Samsung als Konkurrenz zu Dolby Vision forciert. Viele exklusive Partner der Anfangszeit, etwa Panasonic, fahren mittlerweile jedoch zweigleisig. Das bedeutet bis auf Samsung setzen fast alle Unterstützer von HDR10+ parallel auch auf Dolby Vision. Eventuell kann Samsung da aber ja nun im mobilen Bereich mit Partnern wie Google punkten. Denn Smartphones mit Dolby Vision sind hingegen sehr rar gesät.

Sicherlich freut sich also mancher Smartphone-Nutzer, dass HDR10+ nun über Google Play Filme & Serien strammsteht.

Geht das dann auch mit Philips tvs aus 2018/19? Habe den OLED 803 der ja leider nur hdr10+ kann und noch kein Dolby Vision.

The never ending Story. Beide Formate sind bisher überwiegend nutzlos, da sie keine signifikante Qualitätsverbesserung liefern, und das wird sich vermutlich auch nicht mehr ändern. Vielleicht profitiert DV irgendwann mal vom 12Bit-Container, aber das wird sicherlich auch noch viele Jahre dauern.

DV und nutzlos? LoL.

Hast du es denn schon mal live an einem LG oder Panasonic OLED gesehen?

Der Unterschied ist dort deutlich zu sehen. Alleine schon, weil das Tone Mapping dort individuell fürs eigene Display stattfindet. Bei den Sony TVs ist das ja anders, die nur die Low Latency Variante nutzen, wo der Player das TM auf Basis des EDIDs macht. Da ist es dann tatsächlich nicht so spektakulär.

Aber gerade bei OLEDs fällt der Unterschied zwischen HDR10 und DV deutlich auf. Selbst wenn man DTM beim LG nutzt, da die Funktion ja das Ganze Bild erhellt oder verdunkelt. Einzig der Panasonic HDR Optimizer schafft da gute Ergebnisse, die schon nahe an DV rankommen. Wobei den ja eben nicht jeder hat und man im Idealfall aber auch das statische Tone Mapping vom TV komplett ausschalten sollte. Waa LG TVs ja aber nur mit der HGiG Funktion im HDR Game Mode können.

Vielleicht bezieht er sich darauf, dass das Bild eben oft auch verschlimmbessert wird mit DV, oder es vor allem nur sinnvoll bei leuchtschwachen TVs ist. Oled würde z.B. ich auch nicht ohne DV wollen.

Bei DV wird doch aber nichts verschlimmbessert.

Zumindest in den Cinemaprofilen.

Der Sinn bei DV ist ja eben einen akkuraten Look zu erhalten.

…Anders als ja bspw. bei Dynamic Tone Mapping oder dem Panasonic HDR Optimizer, wo mit Algorithmen versucht wird HDR10 „besser“ zu machen. Dabei geht ja aber eben der „Creators Intend“ verloren. Bei DV ist dass ja aber nicht der Fall.

Tonemapping bedeutet meistens Downscaling, das verstehen viele scheinbar nicht. Außerdem haben mittlerweile alle Hersteller eigene dynamische Verfahren entwickelt, statische HDR Metadaten zu adaptieren bzw. zu optimieren. HDR+ etc. Sicherlich mag es einige gute DV und HDR10+ Beispiele geben, aber die Unterschiede zum statischen HDR10 sind i.d.R. marginal, insbesondere auf HDR1000 fähigen Geräten.

Ich empfehle dringend sich noch mal damit auseinandertzsetzen was Tone Mapping macht. Nein. Tone Mapping ist kein „Downscaling“. Hier nur eine grobe Kurzform:

– Kein aktuelles Consumergerät ist in der Lage HDR Content so anzuzeigen, wie es bspw. die Leute in der Post-Produktion sehen.

– Tone Mapping sorgt also dafür, dass HDR Bilder möglichst ohne Detailverluste auf unseren aktuellen Fernsehern, Beamern usw. angezeigt werden können. Man kann es auch als Kompression des Dynamikumfangs beschreiben.

– Würde es kein Tone Mapping geben, würde es bspw. in hellen Bildementen, die heller sind als das was das Display kommt zu Hardclipping kommen. Hier verweise ich bspw. auf die HGiG Option, die genau das bei LG TVs macht.

Und ja. Diverse Hersteller haben ihre eigenen „dynamischen Verfahren“ entwickelt. Diese Verfahren manipulieren aber das Bild, wodurch es eben nicht mehr so aussieht, wie es vom „Creator“ gewollt ist. Weswegen viele Enthusiasten eben diese Features deaktivieren und auf statisches Tone Mapping vertrauen. Bei LGs Dynamic Tone Mapping ist es bspw. so, dass der Algorithmus Einfluss auf das komplette Bild nimmt. Es abdunkelt oder aufhellt, wodurch das Bild eben so abgeändert wird, dass es nicht mehr viel mit dem „Original“ zu tun hat.

Dolby Vision auf der anderen Seite garantiert dir eben, dass das Bild so aussieht, wie es von dem Creator gewollt ist. Das ist der riesen Vorteil von Dolby Vision gegenüber HDR10+ oder Sachen wie Dynamic Tone Mapping.

Was natürlich richtig ist ist, dass Verfahren wie HDR10+, DV etc. für „High Brightness“ LCDs unwichtiger sind. Einfach weil da von Haus aus schon mehr Headroom ist und einfach weniger Tone Mapping angewendet werden muss. Hier kommt es aber auch immer auf das Medium an. Manche Filme gehen ja auch bis 4000 Nits (Rogue One) oder gar 10000 Nits. Wobei auch gerade viele Spiele bis 10000 Nits gehen. In solchen Fällen würde man auch bei „High Brightness LCDs“ wieder massiv durch dynamische HDR Verfahren profitieren.

Hallo, bitte nicht Fernseher und Beamer in einem Atemzug nennen wenn kein Fachwissen vorliegt. Wenn ich einen Film anschaue ( hdr10 oder DV) dann schalte ich Zwischenbild Berechnung und isf ein.

Mein Beamer wurde 3fach kalibriert. Für dunkle 24p Kinofilme, für helle 24p Kinofilme und für 24p Kinofilme in nicht abgedunkelten Raum. Die Parameter wurden mit isf Vorgaben abgeglichen und zum Abrufen eingespeichert. Mein Händler riet mir HDR am Fire Stick auszuschalten. Warum?? Weil nur der Kontrast angehoben wird und sonnst nichts passiert. Bei 2m Bildbreite und 3,70 Meter Sehabstand merkt man eben nur das aufhellen des Bildes. Es gibt Fernseher die ein ortentliches Bild machen ohne irgend etwas einstellen zu müssen. Ich wollte wieder Mal einen TV und hätte beinahe den LG mit 86 Zoll gekauft aber dann entschied ich mich wieder für einen Beamer.

Bei Beamern würde ich HDR auch ausschalten, da die nicht wirklich hell werden und auch kein richtiges Schwarz können. Von daher fehlt es denen am Kontrast.

Trotzdem gibt es eben HDR Beamer. Und für die gilt das gleiche Prinzip. Nur muss das Tone Mapping hier eben wirklich stark sein.

Wie kann man denn am Fire TV HDR ausschalten?

„HDR10+ wurde in erster Linie von Samsung als Konkurrenz zu HDR10+ forciert.“ –> das sollte wohl eher „als Konkurrenz zu Dolby Vision“ heissen.

Danke, ist korrigiert :-).